DeepSeek-r1 is een gratis open source large language model (LLM) dat ontwikkelt is door het gelijknamige bedrijf ‘DeepSeek’. DeepSeek heeft een schokgolf in de tech-/AI-community veroorzaakt omdat het nieuwe r1-model op een aantal punten afwijkt van andere taalmodellen zoals ChatGPT, Claude en Sonnet:

- DeepSeek is Open Source

- Er zijn papers over gepubliceerd

- Het maakt gebruik van reinforcement learning in plaats van supervised finetuning

- Naar verluid is er maar een fractie van de hardware die de concurrentie gebruikt ingezet om het te trainen

- Je hebt minder zware hardware nodig om het zelf te hosten

Je kunt DeepSeek-r1 gebruiken via een chat, vergelijkbaar met ChatGPT, maar ook via een API en het integreren in je eigen applicaties. In deze handleiding laten we zien hoe je Deepseek-R1 zelf host en gebruikt.

Wil je meer weten over de techniek achter DeepSeek-r1? De onderliggende code van DeepSeek-r1 vind je op Huggingface (simpel gezegd een online AI community). Lees ook de door DeepSeek gepubliceerde paper op Github.

Vereiste hardware

Voor het hosten van LLM's is stevige computerhardware nodig en voor het top model van DeepSeek is dit niet anders. DeepSeek-r1 is gelukkig goed geoptimaliseerd en daardoor prima zelf te hosten. Zo zijn er varianten met en zonder 4-bit quantization (een soort compressie) en zijn er varianten beschikbaar met verschillende hoeveelheden parameters. Simpel gezegd geeft het aantal parameters aan hoe groot en complex het model is. Hoe meer parameters, hoe accurater doorgaans de antwoorden. In deze handleiding gebruiken we enkel de 4-bit quantization varianten.

- Enkel het 671b model maakt gebruik van reinforcement learning en komt het dichtst bij het o1-model van OpenAI qua performance.

- Heb je zelf geen stevige GPU en wil je een iets groter model hosten? Bij TransIP kun je een OpenStack-instance aanmaken met een 24GB A30 GPU van Nvidia. Deze is geschikt om het 32b model te hosten.

- De M4 Mac Mini blijkt bijzonder geschikt voor het hosten van DeepSeek, zie deze blog over een ervaring met een M4-cluster.

Wanneer je DeepSeek-r1 lokaal host, is het mogelijk om een model te draaien met minder dan de aangegeven hardware. Dit heeft echter een negatieve impact op de performance. Zo kun je bijvoorbeeld het 70b model gebruiken met een 24gb videokaart, maar het zal een paar minuten duren voor die op gang komt en de output vergt vervolgens ook enkele minuten. We raden daarom aan om de volgende richtlijnen te volgen:

| Parameters | vRAM vereiste (4-bit quantization) |

| 1.5b | 1 GB |

| 7b | 4 GB |

| 8b | 4.5 GB |

| 14b | 8 GB |

| 32b | 18 GB |

| 70b | 40 GB |

| 671b | 336 GB |

Stap 1

Voor de installatie van Deepseek-R1 gebruiken we Ollama. Dit is een erg handige tool waarmee je eenvoudig lokaal een LLM kunt hosten, bijvoorbeeld Deepseek-R1, LLama 3.3, Phi-4 en meer.

Linux (Ubuntu, AlmaLinux etc)

Je download en installeert Ollama eenvoudig met één commando:

curl -fsSL https://ollama.com/install.sh | shWindows

Download Ollama via de knop hieronder. Start het gedownloade bestand en klik op ‘Install’.

MacOS

Download Ollama via de knop hieronder. Start het gedownloade bestand en klik op ‘Install’.

Stap 2

Ollama wordt automatisch uitgevoerd. In het geval van Linux betekent dit dat je vanuit de terminal direct Ollama een commando kunt geven. In Windows moet je de command prompt starten (Windows start-knop > cmd) en in MacOS een terminal.

Nu installeer je eenvoudig het gewenste Deepseek-model met een van de volgende commando's:

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5bDeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7bDeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8bDeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14bDeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32bDeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70bDeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:671bJe kunt optioneel meerdere van de bovenstaande commando's uitvoeren en wisselen welk model je gebruikt tijdens het gebruik van DeepSeek. Let wel dat als meer dan 1 persoon tegelijk via verschillende modellen prompts uitvoert dat het vRAM-gebruik verhoogt.

Sluit tot slot de Ollama-terminal-sessie met het commando:

/byeJe kunt nu direct gebruik maken van DeepSeek! Wil je vanaf een ander apparaat DeepSeek gebruiken? Lees dan eerst de volgende paragraaf.

DeepSeek gebruiken vanaf een ander apparaat

Het is mogelijk DeepSeek te gebruiken vanaf een ander apparaat dan het apparaat waarop je Ollama hebt geïnstalleerd. Hiervoor is een kleine aanpassing nodig in de configuratie van Ollama.

Als je deze optie gebruikt, raden we aan om de beveiliging van je server niet te vergeten. Stel bijvoorbeeld een IP-restrictie in je firewall in voor poort 11434 (de poort die Ollama gebruikt) zodat je enkel vanaf je eigen IP-adres(sen) toegang hebt. Eventueel kun je dit combineren met een eigen VPN-server.

Linux

Stap 1

Open de Ollama-service-configuratie:

nano /etc/systemd/system/ollama.service

Stap 2

Voeg onder het blok [Service] de volgende twee regels toe:

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"Sla de wijzigingen op en sluit het bestand (ctrl + x > y > enter).

Stap 3

Herlaad systemd en herstart Ollama om de wijzigingen te verwerken:

systemctl daemon-reload

systemctl restart ollamaJe kunt nu ook vanaf een ander apparaat gebruik maken van DeepSeek, bijvoorbeeld vanaf je telefoon, zie de volgende paragraaf.

MacOS

Voer de volgende commando's uit en herstart daarna de Ollama applicatie:

launchctl setenv OLLAMA_HOST "0.0.0.0"

launchctl setenv OLLAMA_ORIGINS "*"Je kunt nu ook vanaf een ander apparaat gebruik maken van DeepSeek, bijvoorbeeld vanaf je telefoon, zie de volgende paragraaf.

Windows

Stap 1

Sluit Ollama af. Onderaan rechts op de taakbalk is er een icoontje (mogelijk verborgen onder het pijltje omhoog) waar je met de rechter muisknop op kunt klikken en vervolgens ‘Quit Ollama’ kunt selecteren om het af te sluiten.

Stap 2

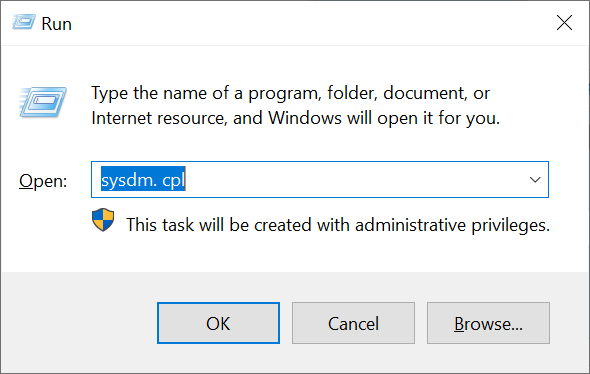

Druk tegelijkertijd op je toetsenbord op het Windows Start-icoon + R. Het uitvoeren/run-scherm verschijnt. Type hier het commando 'sysdm.cpl' en druk op 'OK' of de enter-toets.

Stap 3

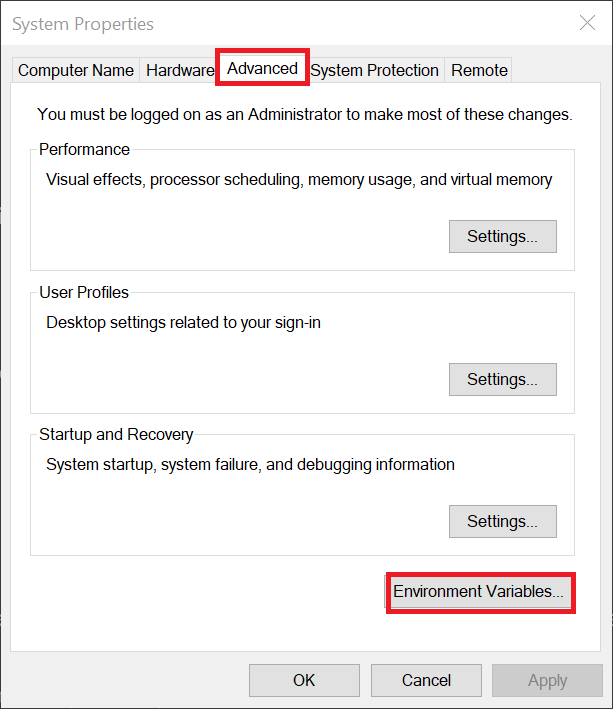

Klik op het tabblad 'Advanced' > 'Environment Variables'.

Stap 4

Klik onder ‘User variables for <jegebruikersnaam>’ op ‘New…’.

Een ‘New User Variable’-pop-up-venster verschijnt. Gebruik als ‘Variable name’ de naam ‘OLLAMA_HOST’ en als ‘Variable value’ de waarde ‘0.0.0.0’ en klik op ‘OK’

Herhaal deze stap en voeg deze keer een variabele toe met de naam ‘OLLAMA_ORIGINS’ en de waarde ‘*’.

Start tot slot Ollama opnieuw op. Je kunt nu ook vanaf een ander apparaat gebruik maken van DeepSeek, bijvoorbeeld vanaf je telefoon, zie de volgende paragraaf.

DeepSeek gebruiken

Het moment waar je op zat te wachten is aangebroken: het gebruik van DeepSeek. Er zijn meerdere opties beschikbaar om DeepSeek te gebruiken, maar we raden er twee aan:

- Chatboxai: een chat programma enigszins vergelijkbaar met ChatGPT)

- API: dankzij de integratie van DeepSeek in Ollama is jouw self-hosted DeepSeek-r1 model via een API beschikbaar

ChatboxAI

ChatboxAI is een AI client applicatie waarmee je eenvoudig verbindt met vele AI modellen en APIs vanaf je computer, telefoon, of tablet. Je installeert en gebruikt ChatboxAI zeer eenvoudig en op (grotendeels) dezelfde manier op al je apparaten:

Stap 1

Download ChatboxAI vanaf https://chatboxai.app of de link hieronder. Open het gedownloade bestand en doorloop de installatie.

Stap 2

Chatbox start doorgaans automatisch, zo niet, start het dan op. Je krijgt nu een automatische configuratiewizard te zien en kunt eventueel de instellingen altijd aanpassen via het ‘Settings’-tandwiel. Pas de volgende gegevens aan:

- API Host: Pas dit enkel aan als je DeepSeek vanaf een ander apparaat gebruikt dan het apparaat waar je het op host. Wijzig in dat geval het local host IP-adres http://127.0.0.1:11434 naar het externe IP-adres van je server/computer, bijvoorbeeld http://123.123.123.213:11434.

- Model: Selecteer het gewenste deepseek-model. Je kunt dit later altijd aanpassen in een chatsessie.

Je kunt nu direct aan de slag met DeepSeek via Chatboxai. Er zijn al een paar voorbeelden automatisch opgenomen in Chatbox waarin het model een instructie mee heeft gekregen, zoals in het voorbeeld hieronder waarin DeepSeek de instructie krijgt om zich te gedragen als een softwareontwikkelaar.

API

Een van de handigste features van DeepSeek via Ollama is dat je zonder kosten gebruik kunt maken van een API om DeepSeek in je eigen project te integreren. Als kers op de taart werkt dit ook nog relatief eenvoudig. Hieronder geven we een Python voorbeeld, maar neem ook gerust een kijkje in de documentatie van DeepSeek voor andere opties.

Vereisten

- Python (een up-to-date versie): Veel besturingssystemen ondersteunen python out-of-the-box en de installatie valt dan ook buiten de scope van deze handleiding.

- De OpenAI module voor Python: Installeer de module via een terminal/cmd met het commando: pip install openai

De basics

Stap 1

Maak een .py-bestand aan (bijv ai.py) en voeg de volgende code toe:

import openai

client = openai.Client(

base_url="http://127.0.0.1:11434/v1",

api_key="ollama"

)

response = client.chat.completions.create(

model="deepseek-r1:32b",

messages=[{"role": "system", "content": "You're a helpful assistant."},{"role": "user", "content": "Hello"}],

temperature=0.7

)

print(response.choices[0].message.content)- Pas optioneel 127.0.0.1 aan naar het publieke IP-adres van je server en 32b (achter model =) naar het aantal parameters van het gebruikte model.

- “You're a helpful assistant.” is de instructie voor het model voor de chat begint. Je bent vrij dit een stuk uitgebreider te maken.

- “Hello" is jouw prompt/vraag aan DeepSeek. Pas dit uiteraard ook naar wens aan

- Het print-commando zorgt ervoor dat de output van DeepSeek in je terminal getoond wordt.

Stap 2

Voer het .py bestand uit, bijvoorbeeld (in Windows):

c:\DeepSeek>ai.pyDe output ziet er ongeveer als volgt uit:

<think>

Okay, the user asked me to act as a helpful assistant. I need to respond in a friendly and approachable way. Maybe say something like, "I'm here to help! How can I assist you today?" That should cover it.

</think>

Hello! I'm here to help. What do you need assistance with?So far so good: DeepSeek laat zijn gedachte zien en die zal bij herhaaldelijk gebruik van dezelfde prompt variëren. Maar… na het uitvoeren van ai.py wordt eenmaal het script uitgevoerd en afgesloten. Hoe kun je in een terminal een doorlopende chatsessie voeren? Dat brengt ons bij de volgende paragraaf

Een doorlopend gesprek voeren

Na de basics ben je al een heel eind. Voor het gemak laten we hieronder nog een voorbeeld zien hoe je een doorlopend gesprek voert, met dank aan DeepSeek die zelf dit voorbeeld genereerde:

import openai

# Create the client

client = openai.Client(

base_url="http://127.0.0.1:11434/v1",

api_key="ollama"

)

# Start your conversation history

messages = [

{"role": "system", "content": "You're a helpful assistant."}

]

while True:

# Ask for user input

user_input = input("User: ")

# If user types something like 'exit' or 'quit', break out

if user_input.lower().strip() in ["exitchat", "quitchat"]:

print("Exiting...")

break

# Add the user's message to the conversation

messages.append({"role": "user", "content": user_input})

# Generate assistant response

response = client.chat.completions.create(

model="deepseek-r1:32b",

messages=messages,

temperature=0.7

)

# Grab the assistant's reply

assistant_reply = response.choices[0].message.content

print("Assistant:", assistant_reply)

# Append assistant message to the conversation so context is maintained

messages.append({"role": "assistant", "content": assistant_reply})- Pas optioneel 127.0.0.1 aan naar het publieke IP-adres van je server en 32b (achter model =) naar het aantal parameters van het gebruikte model.

- “You're a helpful assistant.” is de instructie voor het model voor de chat begint. Je bent vrij dit een stuk uitgebreider te maken.

- “User:" geeft aan dat dit is waar jouw input komt

- exitchat en quitchat sluiten de chatsessie af

Voer het .py bestand uit, bijvoorbeeld (in Windows):

c:\DeepSeek>ai.pyDeze keer kun je daadwerkelijk een chat-sessie voeren met DeepSeek. Pas op: het denkproces (<think>….</think>) kan behoorlijk uitgebreid zijn.

Daarmee zijn we aan het eind gekomen van deze handleiding over het zelf hosten van DeepSeek. Veel succes!